我是Python新手,需要数据块方面的帮助。

我需要使用 Python 将文件从 Azure Blob 复制到 ADLS。

我需要Python文件中的代码,并需要从数据块而不是笔记本上执行。

我尝试了下面的方法,

使用spark.conf.set,我设置了Blob和ADLS的访问密钥。我使用dbutils.fs。cp复制文件。

它执行时没有任何错误,但文件实际上没有复制到ADLS。

任何帮助将不胜感激。

谢谢

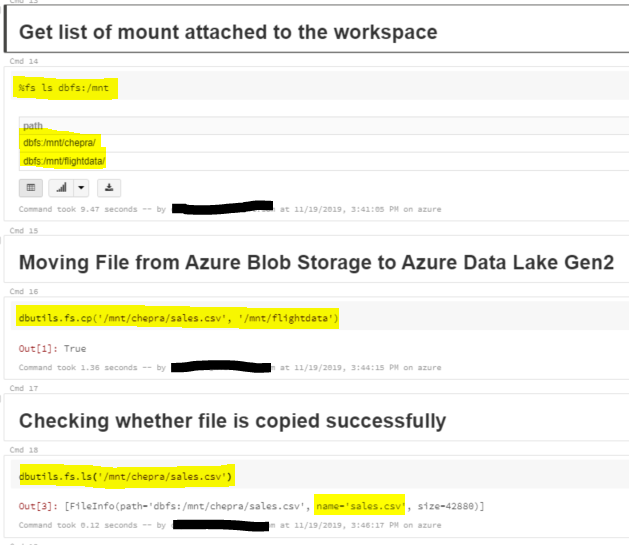

我能够使用Databricks实用工具命令(dbuitls.fs.cp(“源”,“目标”)将文件从Azure Blob存储移动到ADLS:

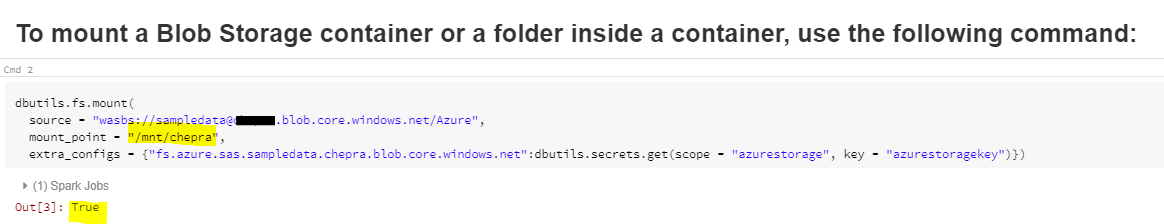

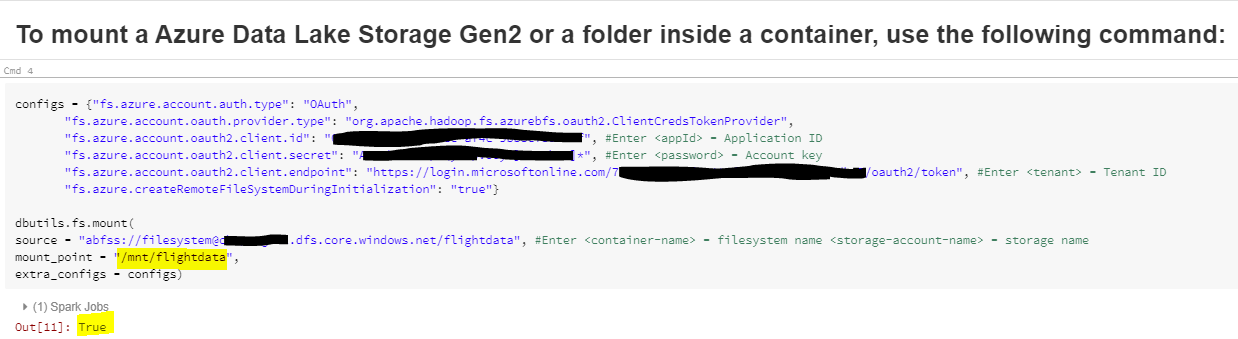

首先,我安装了名为(/mnt/chepra)的Azure Blob存储帐户和名为(.mnt/flightdata)的ADLS Gen2帐户。

Azure Blob存储挂载:(/mnt/chepra)

Azure Data Lake Storage (/mnt/flightdata)

现在,您可以使用data ricks实用程序命令从Azure Blob存储cp到Azure Data Lake Storage,如下所示:

dbutils.fs.cp('/mnt/chepra/sales.csv', '/mnt/flightdata')

希望这能有所帮助。